Киберпреступники теперь не просто предаются случайным экспериментам с искусственным интеллектом в ходе кибератак, а используют его в качестве штатного инструмента, к которому регулярно производятся обращения со стороны вредоносного ПО. Об этом предупредили эксперты Google Threat Intelligence Group.

Итоги 2025-го: ИИ-лихорадка, рыночные войны, конец эпохи Windows 10 и ещё 12 главных событий года

Обзор ноутбука TECNO MEGABOOK S14 (S14MM): OLED с HDR как новая норма

Итоги 2025 года: почему память стала роскошью и что будет дальше

Обзор игрового 4K IPS-монитора Gigabyte M27UP: разнообразия ради

Обзор телевизора Sber SDX-43U4169

Обзор игрового QD-OLED WQHD-монитора Gigabyte AORUS FO27Q5P: на пределе возможностей

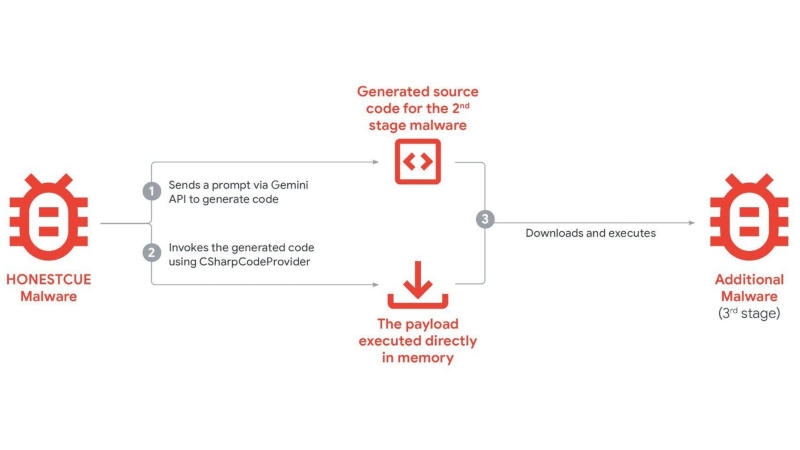

Некоторые семейства вредоносного ПО совершают прямые вызовы к ИИ-помощнику Gemini при совершении кибератак, обратили внимание исследователи в области кибербезопасности из Google. Вредоносы динамически направляют запросы на генерацию кода у модели при выполнении определённых задач, что позволяет не включать соответствующие фрагменты в основной код. Так, вредоносы семейства HONESTCUE отправляли запросы на генерацию кода C#, который выполнялся в цепочке атак. Логика выносится за пределы статического бинарного файла, что усложняет традиционные методы обнаружения по сигнатурам или поведенческим индикаторам.

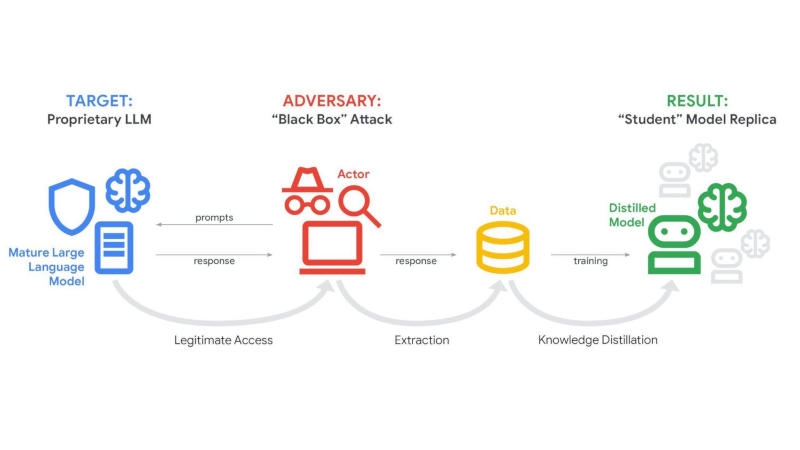

Ещё один тип атак — попытки копирования моделей ИИ через дистилляцию. Злоумышленники отправляют моделям большие объёмы структурированных запросов, чтобы скопировать её поведение, шаблоны ответов и внутреннюю логику. Систематически анализируя выходные данные, злоумышленники с некоторой точностью воспроизводят возможности закрытых моделей ИИ, обучая альтернативные системы и не неся при этом затрат на разработку и инфраструктуру, связанных с разработкой с нуля. Google удалось выявить и пресечь кампании, связанные с большими объёмами запросов, направленных на извлечение знаний из моделей Gemini.

Активно повышается частота использования ИИ у хакерских группировок, действующих при поддержке правительств. ИИ используется в разведке, изучении уязвимостей, разработке скриптов и генерации фишингового контента. Модели генеративного ИИ оказываются полезными в создании убедительных приманок, отладке фрагментов вредоносного кода и ускорении технических исследований против целевых систем. Киберпреступники изучают возможности агентного ИИ — он может разрабатываться для выполнения многоэтапных задач с минимальным участием человека, то есть будущие вредоносы, вероятно, получат элементы самостоятельного принятия решений. На практике такие средства пока не используются — они дополняют, но не заменяют живых операторов.

Добавить комментарий