Anthropic внесла важные изменения в политику обработки данных пользователей и предложила им до 28 сентября принять решение, хотят ли они использовать свою переписку с чат-ботом для обучения моделей искусственного интеллекта.

Обзор рейтингового режима Warface: просто освоиться, сложно оторваться

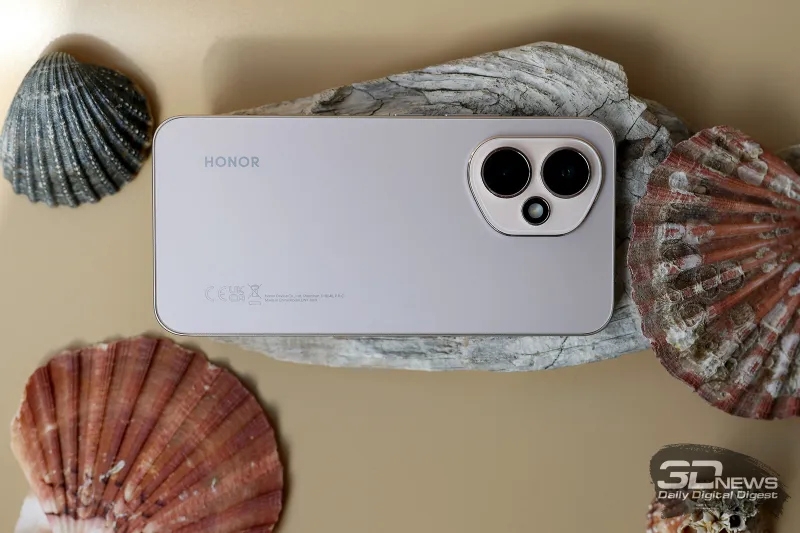

Обзор смартфона HONOR 400: реаниматор

Обзор ноутбука Acer Swift Go 14 (SFG14-63-R7T4) с процессором Ryzen 9 8945HS и OLED-экраном

HUAWEI Pura 80 Ultra глазами фотографа

Пять причин полюбить HONOR 400

Обзор смартфона HUAWEI Pura 80 Ultra: зум, которому нет равных

Ранее Anthropic не использовала журналы чатов для обучения моделей — пользователей заверяли, что их запросы и ответы чат-ботов автоматически удаляются из систем в течение 30 дней «за исключением случаев, когда требования закона или политики [компании] предусматривают более продолжительный срок». Если запросы получали отметку как нарушающие правила обслуживания, то они хранились до двух лет. Теперь же она решила добавить в массивы обучающих данных обычную переписку и сессии с написанием программного кода — если пользователь даст согласие, эти данные будут храниться пять лет. Речь идёт только о потребительском сегменте сервиса, то есть о частных пользователях Claude Free, Pro и Max, в том числе тех, кто работает с Claude Code. У пользователей корпоративного сектора, в том числе сервисов Claude Gov, Claude for Work, Claude for Education, а также работающих через API компания собирать данные переписок для обучения ИИ не намерена.

В стремлении убедить пользователей согласиться на новую политику обработки данных Anthropic отмечает, что так они «помогут нам повысить безопасность модели, сделав наши системы обнаружения вредоносного контента более точными и снизив вероятность реагирования на безобидные разговоры». Согласившись передавать журналы переписки на обучение ИИ, пользователи «также помогут нашим будущим моделям Claude улучшить такие навыки как программирование, анализ и рассуждения, что в конечном счёте приведёт к созданию более качественных моделей для всех». И действительно, отмечает TechCrunch, для обучения передовых моделей ИИ требуются колоссальные объёмы высококачественных разговорных данных, и доступ к миллионам чатов с Claude откроет ей источник материалов, способных улучшить позиции Anthropic как конкурента OpenAI и Google.

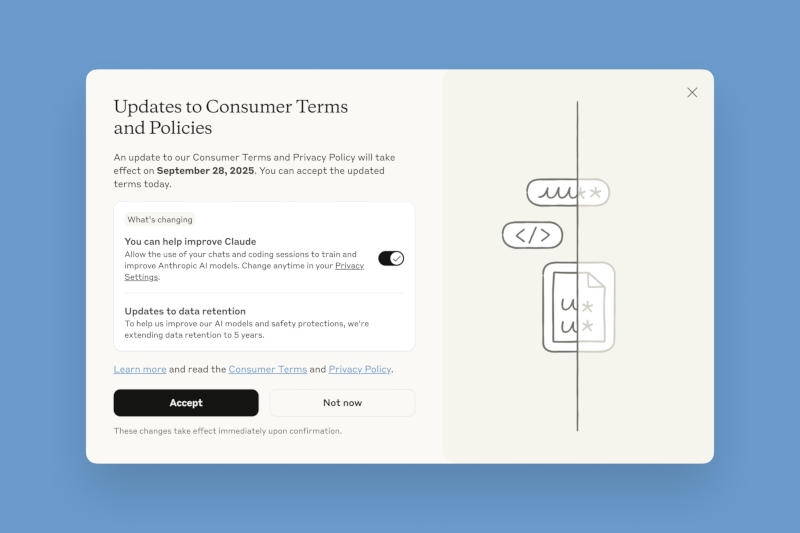

К нужному выбору компания подталкивает пользователей, делая нужные акценты в интерфейсе сервисов. Тем, кто только регистрируется, дают (или не дают) согласие при заполнении профиля; существующим же выводится всплывающее окно с заголовком «Обновления условий и политики для потребителей», включённым по умолчанию триггером согласия на передачу данных и большой чёрной кнопкой «Принять». Увидев такое окно, невнимательный или равнодушный пользователь может быстро нажать эту кнопку, не вдаваясь в подробности.

Добавить комментарий